Иногда возникает необходимость временно скрыть сайт от индексации поисковых систем, особенно на этапе разработки. Это делается, чтобы избежать попадания недоработанного контента в индекс или для тестирования изменений на копии сайта.

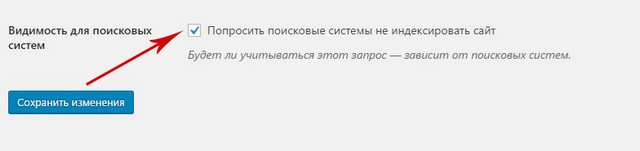

Например, если ваш сайт на WordPress, то самый простой метод – использование встроенных настроек:

WordPress автоматически обновит файл robots.txt, запрещая индексацию. Важно помнить, что это является рекомендацией, а не прямым запретом, и Google может проигнорировать его.

Если вы используете другую CMS, то нужно посмотреть есть ли в настройках подобная функция запрета индексации.

Если в вашей CMS нет таких настроек, то закрыть веб-сайт для поисковиков можно вручную через файл robots.txt.

Важно! Я уже упоминал об этом выше, что для поисковых машин данный файл несет лишь рекомендательный характер, и окончательное решение по индексированию остается за ними.

Создайте обычный текстовый документ в формате txt, и назовите его robots.

Затем загрузите его в корневую папку своего проекта, чтобы этот файл мог открываться по такому пути site.ru/robots.txt. Пример, мой файл robots открывается и содержит такую информацию https://webmasterie.ru/robots.txt

Но у вас он должен быть пусто, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его страницы. Рассмотрим все варианты, которые вам могут пригодиться.

Пропишите в robots.txt команду:

User-agent: *

Disallow: /Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt.

Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы разместили файл не в том месте, либо ваш движок сайта ограничивает доступ к файлу.

Прописав эти параметры вы скроете все файлы, находящиеся в указанной папке.

User-agent: *

Disallow: /folder/Закрыть сайт от индексации только для поисковой системы Яндекс.

User-agent: Yandex

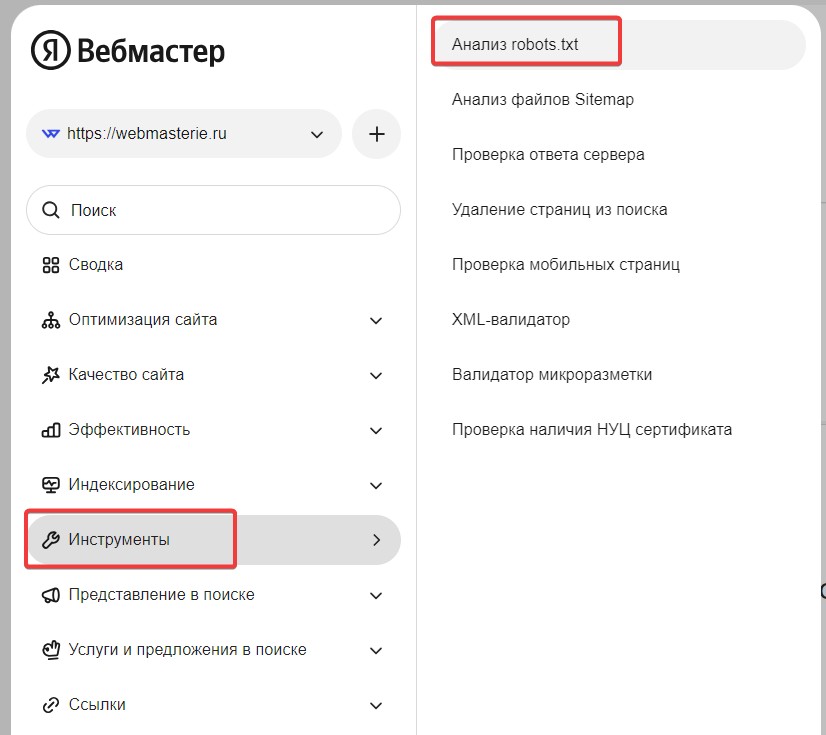

Disallow: /Чтобы перепроверить, получилось ли у вас закрыть свой сайт для Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в «Инструменты» и «Анализ robots.txt».

Здесь вы увидите содержимое вашего файла и даже сможете посмотреть историю его изменения, кликнув на поле версия. Но нам нужно прокрутить страницу вниз до формы «Разрешены ли URL?».

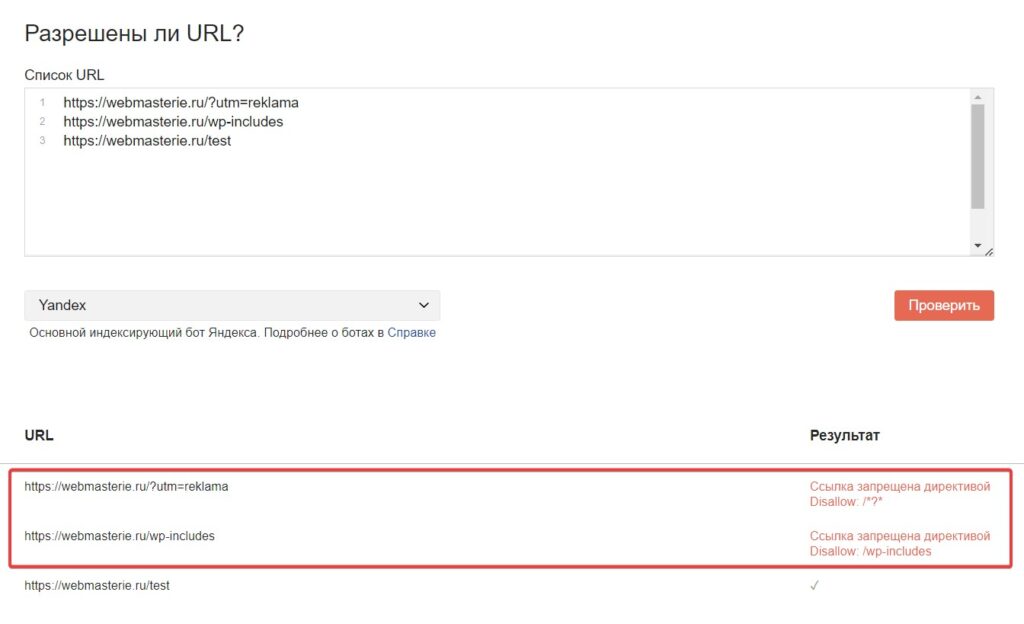

Вставьте несколько ссылок на страницы вашего ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах вы увидите отмеченный результат красным цветом, который указывает, какая переменная закрывает эту страницу от индексации в robots.txt.

Если видите зеленую галочку, то значит этот документ будет доступен для роботов.

Закрыть весь сайт от индексации только для поисковой системы Google.

User-agent: Googlebot

Disallow: /Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды.

Самые распространенные (кроме Яндекса и Google):

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

User-Agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gifЛюбой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

User-agent: *

Disallow: /Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

Если хотите узнать больше команд для robots.txt, то можно посетить сайт https://robotstxt.ru.

Использование мета-тега robots – еще один способ, который поможет скрыть от роботов поисковых систем какую-либо страницу или полностью весь сайт.

Данный вариант является одним из самых приоритетных к исполнению для поисковиков. Для этого в любом месте внутри тегов <head> и </head>, нужно прописать код на той странице которую вы хотите закрыть от индексации:

<meta name=”robots” content=”noindex, nofollow”/>или

<meta name=”robots” content=”none”/>К этому варианту вебмастера прибегают в тому случае, когда роботы вообще никак не реагируют на действия, описанные выше.

Такое иногда случается, и тогда приходится решать проблему в настройках сервера посредством файла .htaccess. Он находится в корне вашего сайта. Откройте его и пропишите в нем такие команды:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_bot

SetEnvIfNoCase User-Agent "^Yahoo" search_bot

SetEnvIfNoCase User-Agent "^Aport" search_bot

SetEnvIfNoCase User-Agent "^msnbot" search_bot

SetEnvIfNoCase User-Agent "^spider" search_bot

SetEnvIfNoCase User-Agent "^Robot" search_bot

SetEnvIfNoCase User-Agent "^php" search_bot

SetEnvIfNoCase User-Agent "^Mail" search_bot

SetEnvIfNoCase User-Agent "^bot" search_bot

SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot

SetEnvIfNoCase User-Agent "^Snapbot" search_bot

SetEnvIfNoCase User-Agent "^WordPress" search_bot

SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot

SetEnvIfNoCase User-Agent "^Parser" search_botКак можно понять из команды. Каждая строчка содержит в себе запрет индексации для определенного поискового робота.

Если вы хотите запретить, только Яндекс и Google, то пропишите так:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_botЭто тоже своего рода настройка сервера с помощью файла .htaccess, но этот способ работает на уровне заголовков. Это один из самых авторитетных способов закрытия сайта от индексации, потому что он настраивается на уровне сервера.

Этот серьезный способ подразумевал под собой отдельную статью, потому что там очень много нюансов. В ней я подробно рассказал, как настроить X-Robots-Tag и использовать для закрытия индексации.

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.

Самый простой и в тоже время не всегда исполняемый для поисковых систем метод — это использовать инструкции в файле robots.txt. Meta robots и X-robots-Tag более надежные способы, чтобы запретить индексацию поисковых систем на сайте или странице.